近年来苹果手机一直以其出色的相机性能而备受称赞,无论是新款iPhone还是旧款,其相机像素一直保持在1200万。为什么苹果手机的相机像素一直没有提升呢?在众多手机品牌纷纷推出4800万、6400万像素的摄像头时,苹果为何仍然停留在1200万像素的水平上?这个问题引发了人们的好奇与讨论。在探索其背后原因之前,让我们先来了解一下这样的设计背后的意义和影响。

iPhone相机的像素为什么一直保持在1200万

这么多年iPhone像素一直没变,但是其综合拍照能力却处于第一梯队,这背后的原因到底是什么?

搞清楚 像素高不一定拍照就好

很多用户认为手机像素越高就越好,手机摄像头的像素固然对手机的成像有着很大的影响,但要搞清楚的是,像素高并不意味着拍照就好。

像素是构成一张照片的最小单位,我们看到的图片其实都是由每一个像素点组成,而每一个单独的“色点”就是我们常说的像素。

一张图片由1200万个色点组成,那么图片像素就是1200万。

成像效果并非取决于像素高低,感光元件的大小更加重要。胶片时代感官元件指的是底片,而发展到现在的智能手机年代,感光元件就是指镜头后面用来接收光线的一块“小板”。

成像画质的好坏取决于感光元件捕捉到光的多少来决定,感光元件越大,能捕捉到的光线就越多,传感器感光性能越好,就能够带来更细腻的画质。

同时,更大的底,在单个像素面积相同的条件下能堆积更多的像素点。

“底大一级压死人”,CMOS对于光线的敏感程度,更直接影响相机在暗光环境下的成像表现。

当下厂商宣传的手机夜景成像能力,正是得益于大底传感器的加持,而不是由像素高低决定。

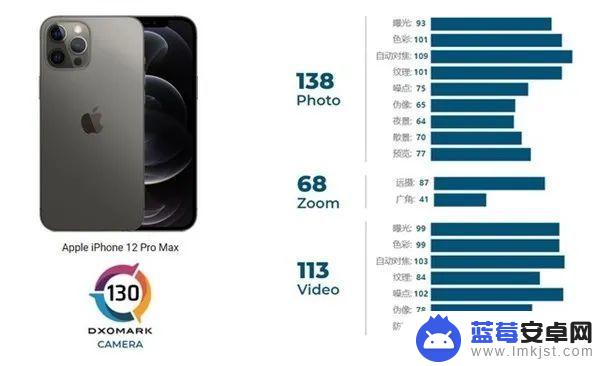

举个例子,iPhone 12 Pro Max虽然是1200万像素,苹果专门为其定制了一枚1/1.7英寸的大底传感器,其感光元件尺寸增大47%,像素尺寸增大至1.7 微米,低光拍摄效果更是提升高达87%。

iPhone的像素虽然没变,但传感器等硬件却不断升级,这是其成像水平保持稳定在第一梯队的重要原因之一。

手机成像是一个系统性的工程 苹果资源整合能力强

像素高只能证明图像承载的信息多、细节丰富,但并不能代表照片质量一定就高。手机的成像质量,除了受像素影响外,还与手机镜头本身、传感器感光元件、图像信号处理器以及软件算法等有关。

恰巧的是,苹果供应链的整合能力是业界出了名的强,影像方面也毫不例外。

首先,财大气粗的苹果,对于iPhone零部件相来都是独家定制,目前主流手机厂商的传感器供货商只有少数的几家。

而索尼是目前全球最大的影像传感器供货商,苹果同样采用索尼的CMOS。但是其素质却更好,同时也没有任何一家厂商能拿到和iPhone同样的模组,毕竟苹果对于其供应链要求是相当严苛的。

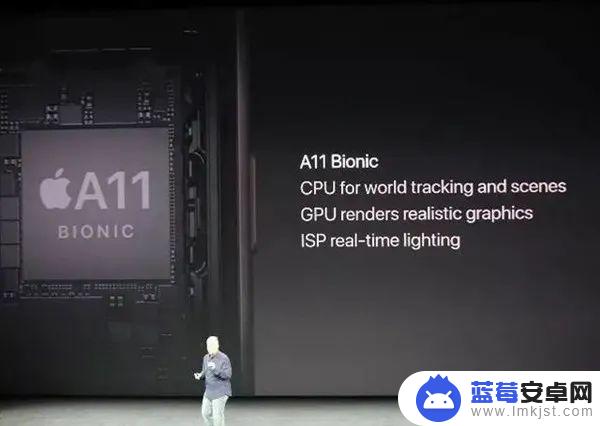

其次,苹果iPhone在软件算法上的积累同样深厚。2017年iPhone X发布,A11仿生芯片也随之面世,之所以称其为“仿生”,是因为苹果在这款芯片上首次集成自研的Neural Engine神经网络引擎,其配合新型的ISP算法,iPhone X率先在业界实现了光照环境侦测等一系列拍照算法。

之后,A系列仿生芯片不断更新换代,其神经网络引擎算法对于拍照的优化也不断增强。

例如,iPhone 12系列的智能HDR3算法,会利用机器学习技术,智能地调节照片的白平衡、对比度、质感和饱和度,让画面看上去更自然。

全新的计算摄影功能,所有摄像头均支持夜间模式和处理速度更快的深度融合技术。应对复杂场景下的拍摄能力进一步增强,苹果能够同时将这些功能算法集于一款手机上,足见其深厚的影像技术功底。

另一方面,新的手机摄像头、感光元件和软件算法之间的协同,任何一家手机厂商都不敢保证能在短时间内完全吃透,它需要花时间去打磨,而苹果而言这也不是问题。

苹果不仅有来自于全球各地的优秀工程师,而且每年只更新一代产品,影像团队有充足的时间去优化产品,相比于其他手机厂商一年发多款产品,苹果显然更有时间上的优势。

定制的镜头、传感器感光元件等硬件,配合影像技术上的深度调教,再加上通过收购吸纳全世界优秀的影像技术团队,最终打造出一套完整的iPhone影像系统。

写在最后

现在消费者选购一款拍照好的手机时,往往会掉进一个误区,那就是仅以像素高低来定手机的成像好坏。手机成像经过多年的技术更迭,发展到现在,早已不是唯手机像素去定胜负了。

手机成像不仅离不开处理器、传感器等硬件的打磨,更离不开软件算法的优化。手机摄像头像素不断提高是行业的趋势,但手机拍照可以说是一整套系统的联动,缺一不可。

高像素、多摄像头的确是手机厂商都在宣传的卖点,因为手机的外观及参数上的变化是普通消费者最容易感知到的,数字的飙升更容易给手机打上高端的标签。

但是,用户能感知到的是最终的结果,最终能够获得好的照片、好的视频就是好的体验,无论硬件还是软件都是需要花时间去打磨的。

以上就是关于苹果手机相机像素的全部内容,如果您也遇到了相同的情况,可以按照小编提供的方法来解决问题。